プロローグ

第3週のテーマは、「実践リスク管理」です。Vol.1、2で習得した基礎と問いの設計技法を、個人・チーム・組織の成長戦略へ統合する段階へと進みます。

| 教材の概要 | GoogleのNotebookLM(無償版)に、本記事URLを読み込ませて自習教材のコンテンツ(音声・動画解説、理解度クイズ、学習ガイド)を生成して自分のペースで学習できます。また、全てを頭から読了するだけではなく、気になるセクションからも自由に学べる、モジュール型の学習コンテンツです。 |

|---|---|

| 学習内容 | 業務直結型のAI活用の基礎スキルを、自分のペースで学べる実践教材。 |

| 対象者 | これから本格的にAIをビジネス活用を考えてるビジネスパーソン、経営層。 |

| 学習方法 | 目安:15-20分/日の自主学習 (+ 30分/最終日にグループワークなどで学習成果の共有) |

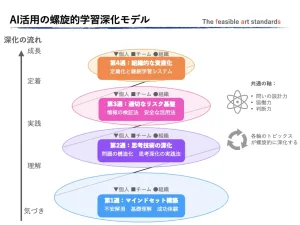

| カリキュラム概要 | 全4週間の構成: 第1週:Vol.1「マインドセット構築とAI基礎理解」 第2週:Vol.2「問いの設計と思考技術」 第3週:Vol.3「実務活用における実践リスク管理」←今回の学習 第4週:Vol.4「継続改善と組織的資産化」 |

| 教材利用における著作権 | 本教材の著作権は、ファズ合同会社に帰属します。 個人利用、非営利用途としての勉強会への無償利用を認めています。 商用セミナーへの教材の利用やWEB掲載、出版、プレゼンテーション資料などへの利用の許諾については、ファズ合同会社までお問合せ下さい。 |

第2週の振り返り※クリック(タップ)すると、解説が表示されます。

第2週では、適切な問いを設計し、複雑な課題を構造化することで、AIを「使える」から「使いこなす」段階へ移行しました。この実践を通じ、AIの出力にはハルシネーションやバイアスといった限界が内在することを再確認しました。AIの結果をそのまま受け取るのではなく、最終判断は人間が担うという姿勢が、Vol.3の「実践的リスク管理」の出発点です。

第3週の目的

AI時代の「人間の責任」の理解を深める

AI技術の進化は、圧倒的な利便性をもたらす一方、「安全に活用するための判断力」が求められています。本章では、AI出力の検証にとどまらず、法的・倫理的リスクを特定し、安全な活用を支える判断基準を体系的に学びます。

リスク管理を「価値創造」の基盤に置く

第1週で培った「入力情報の扱い(PII・社内情報)の重要性」を、Vol.3の目的では確実な守りとするために、「安心」という揺るぎない土台を築くことです。

AIを安全に活用するためには、入力情報の扱い(セキュリティ)/法的側面(著作権)/出力の倫理性といった多面的なリスクへの利用者である個人の対処が不可欠です。

また、法的リスクは、医療・金融・行政など業界規制のにも意識を向ける必要があります。そして、AIの活用の最終的な「責任の所在」を、個人ではなく組織の設計課題へとつながります。※コンプライアンス構築の詳細は、Vol.4(最終章)で,詳細を解説。

本章を通じて、法的・倫理的リスクを特定し、検証・判断・回避のための実践的な枠組みを習得していきます。これにより、安全かつ信頼性の高いAI活用で創造性の拡張を実現させていきます。

第3週で習得する能力

- リスク発生を未然に防ぐ検証手法

- 法的・倫理的リスクの察知

- チームレベルで共有できるリスク判断基準の確立

今回の学習目標

ナレッジ面:

- 公開情報の信頼性を評価する情報リテラシーの4階層モデルを理解してる

- AI出力の3段階検証法(事実性・論理性・公平性)を把握している

- 倫理的判断の軸を習得する

スキル面:

- ファクトチェックの5ステップを実行できる識的に制御できる

- 機密情報を適切に匿名化・抽象化して活用できる

- リスクマップを作成し、リスク対応の優先順位を判断できる

マインド面:

- リスク管理を「制限」ではなく、AI活用を「加速させるための土台」として前向きに捉える

※この記事のURLをNotebookLM(無償版)に読み込むと、動画・音声解説や理解度クイズなどを自動生成され、自律学習に最適化された教材として活用できます。関心のあるモジュールから学びを始めることも可能です。

NotebooLMが生成したサンプル動画解説。(2分23秒)

1.「情報リテラシー」と適切な判断を導く「AI協働プロセス」設計

AI活用において最も重要なスキルの一つが、「情報の本質を見抜き、適切な判断材料を選別する能力」です。AIは高速で大量の情報を処理しますが、生成された情報は「一次情報など」を加工した「二次情報」です。また、情報の信頼性は一様でもありません。

本セクションでは、情報を適切に見抜き判断するための情報リテラシーの基本技術を学び、判断・実行するまでのAI協働プロセスへ学びを進めていきます。

1-1.情報リテラシーを整える情報を見極める「4階層(分類法)」

世の中の公開された情報が等しく信頼できるわけではありません。情報源の性質により、信頼性には明確な階層が存在します。

AIは膨大な情報を統合処理しますが、その精度は入力情報(=機械学習された情報)の「質」によって大きく左右されます。AI協働を行う上で、最初に求められるのは「どの情報を信頼できるか」を見極める力、すなわち情報リテラシーです。

情報の階層を見極める力は、AIと協働する上での最初の防御線であり、リスク管理の基盤を支えるスキルでもあります。

AIが提⽰した統計データには、「信憑性の⾼い階層の情報源を明⽰せよ」などの追加指⽰を⾏い、情報源の信頼性を4階層で人間が最終検証します。

情報の信頼性を分類する4階層モデル

| 階層 | 情報源の特徴 | 具体例 | 活用上の注意 |

|---|---|---|---|

| 第1階層(最高) | 一次情報:公式データ | 政府統計、学術論文、企業の公式発表、実測データ | 出典・調査方法を確認 |

| 第2階層(高) | 専門機関の分析 | シンクタンク報告書、業界団体レポート | 分析目的・発信主体を確認 |

| 第3階層(中) | 一般メディア報道 | 新聞記事、ビジネス誌、ニュースサイト | 複数ソースで照合 |

| 第4階層(低) | 個人発信、SNS投稿、まとめサイト | ブログサイトやキュレーションサイト(まとめサイト) | 事実裏付けなしで採用を避ける |

- 情報の信頼性4階層→公開情報の信頼性評価

- リスク情報の3分類→入力可否の判断基準

情報における信頼性の3つの評価軸

一般的に情報の信頼性を判断する際、以下の3つの評価軸で検証します。

- 情報の確度(Accuracy):収集・分析方法が提示されているか、裏付けとなる一次情報は存在するか

- 情報源の権威性(Authority):誰が、どの機関が情報を発信しているか

- 情報の鮮度と文脈(Context):情報は最新のものか、特定の文脈に限定されていない中立的か

こうした情報評価は、AI出力の誤りや矛盾(誤情報:=ハルシネーション)をも見抜き、

実務でのリスク発生を最小化する第一歩となります。

- AIが示す数値・情報はそのまま採用せず、「鮮度」や「出所」をAIへ問うことを習慣化する

- 出典と発信主体を明示し、更新時期を確認する

- 信頼性の異なる情報を照合し、整合性を確認する

1-2.適切な判断を導く「AI協働プロセス」

見極めた情報を判断に活かすための「思考の3ステップ」

情報リテラシーは「信頼できる情報を選び取る力」です。しかし、真に意味を持つのは、その情報をどう“判断”に活かすかです。AIは結論を代行する存在ではなく、人間が考えるための補助線です。

ここでは、AIと協働しながら思考を深める3つのステップを整理します。それは、情報を検証・統合し、人間の最終判断を支える仕組みです。

判断材料を導く3ステップ

AIに定量情報(数値・データ)を分析させ、傾向分析を多角的に洗い出し可視化し客観的に整理します。(情報入力における注意点は、後ほど解説)

例:解約率の上昇・問い合わせ件数の増加・SNS上の不満投稿比率の上昇などの「顧客離反リスク」の兆候を示すサインをAIが発見。

- 補足:

-

数値の異常値を即座にリスクと判断せず、変化の傾向として背景を探る段階と捉えます。

- 定量分析では「結果」よりも「変化・兆候」に着目する

- 現象を正しく把握することが、判断の安全性を高める

- 定量分析(事実の整理)は、次のSTEP(意味づけ)の基盤となる

数値だけでは見えづらい問題の原因をAIに要因を探らせ 、背後要因や相関関係を多角的に整理します。

例:AIに「問い合わせ文面」や「SNS投稿」を要約させると、「サポート対応の遅延」「機能の誤解」「価格への不満」など、原因候補が抽出。データから⾒える傾向の背景要因を推測し、複数の仮説を導く。

- 補足:

-

AIの分析結果は、可能性の提示であって「正解」ではありません。「どの情報源をもとに、どの期間のデータで分析したか」推論プロセスを確認し、複数の仮説を保持することで、偏りの少ない検討が可能になります。

- データ・数値を意味づけする=定性分析

- AIが出した「結果=提案」には前提条件があると理解する

- 仮説は一つに絞らず、複数の可能性を比較する

- この段階は「原因の断定」ではなく、「問いの精緻化」に重点を置く

AIは定量・定性情報を統合し、影響要因や対応策を提案し、人間はその検証:妥当性・実現性・倫理性で、最終判断へ仕上げます。

- 例:

-

AIが「顧客離反の主因はサポート遅延と価格改定の重なりにある。短期的には対応時間の改善が有効」と判断(提案)。

- 人間は次の観点からAIの生成情報を検証:

-

- 妥当性: 提案はデータや事実と整合しているか

- 実現性: 自社リソースで実行可能か

- 倫理性: 提案により不公平や新たなリスクが生じないか

- 補足:

-

AIの統合提案は判断の“完成形”ではなく、対話的検証の出発点です。必要に応じてAIに追加質問で、複数パターンを比較・検証することで、人間の判断の精度と説明可責任を高めます。

- AIは統合・提案を担い、人間は検証・決定を担う

- 最終判断の責任は人間にあり、AIの提案は補助線と位置づける

- 提案から最終判断・実行は人間の役割

- 最終判断の際は、妥当性・実現性・倫理性の3観点を必ず確認する

- 情報の信頼性の4階層(一次情報から個人発信まで)を峻別し情報源を必ず確認する

- AIが示す情報に対し、出所(出典)と鮮度(更新時期)を問うことを習慣化する

- 重要な決定には、信頼性の高い情報を使い、必ず複数の独立したソースで裏付けを取る

- 情報が客観的な事実か発信者の主観かを明確に分けて判断する

- 発信主体が情報に関する専門性や信憑性を負える組織・個人であるかを判断する

- AI協働で適切な判断を導くための「思考の3ステップ」:

- 定量分析(事実の整理): 数値・データから変化・兆候を可視化

- 定性分析(意味づけ): 背景要因を探り、複数の仮説を保持

- 統合判断: AIの提案を妥当性・実現性・倫理性で検証し、人間が最終決定を担う

次に、情報セキュリティと法的リスクへの判断の土台となる、安全かつ責任を持って対処する具体的な手法を学びます。

2.AI活用時の情報セキュリティと法的リスクへの対処法

リスク管理は「AI活用を制限するもの」ではなく、「安心して活用を加速させるための土台」です。適切なリスク管理があってこそ、思い切った活用が可能になります。

本セクションでは、特に実務で直面しやすい情報セキュリティと法的リスクへの具体的な対処法を学びます。

2-1.情報セキュリティのコア対策:入力情報の識別判断と対応

AIの安全な活用基盤は、「AIに入力する情報」への適切な注意から始まります。特に、個人情報(PII:Personally Identifiable Information)と企業の機密情報の漏洩※を防ぐことは、情報セキュリティの最重要課題です。

※「漏洩」とは、AIのデータ学習のために入力データが外部サーバーへ送られることによる漏洩リスクを指します。

AI活用におけるセキュリティ対策の核心は、Vol.1で学んだ「入力情報の3分類(情報漏洩防止用)」に基づき、入力データの種類に応じて対応を峻別することです。情報漏洩リスクは利便性と表裏一体であるため、この分類を業務に適用し、リスクを最小化します。

2つの情報分類の違い

- 情報リテラシー4階層

-

公開情報の信頼性評価(AI出力の検証用)

- 入力報の3分類

-

情報漏洩防止用(AIへ入力可否の判断基準)

※以下のタイトルをクリック(タップ)すると、詳細な解説が表示されます。

【Vol.1復習】リスク情報(情報漏洩防止用)の3分類 タイトルをクリック(タップ)すると、解説が表示されます。

- リスクレベル:高

-

- データ内容:未公開の財務情報、個人情報、契約情報・法務文書など

- 留意点:自社の独自環境を構築して、AI活用する場合を除く。

- リスクレベル:中

-

- データ内容:議事録・報告書、プロジェクト計画、社内分析資料

- 留意点:匿名化・抽象化などの情報変換を施して利用する。

- 情報の変換例:

-

- 実名 → 役割名

- 固有名称 → 一般名称

- 顧客名 → 抽象表現

- 具体的数値 → 概算レンジ

- リスクレベル:低

-

- データ内容:公開情報である業界情報、一般的なビジネス知識、公開統計データ(論文・白書)

※留意点:出典元の信憑性を確認して、出典先を明示する。

AIへの入力前に、情報がレイヤー3(機密・個人情報、原則入力禁止)、レイヤー2(社内限定情報、匿名化必須)、レイヤー1(公開情報、入力可)のどこに属するかをステップ形式で特定出来るように学習します。

また、入力前に「この情報は本当にAIに入力して良いか?」と自問する習慣をつけます。

情報扱いの「判断プロセス」(「リスク情報の3分類」実践)

- 前提条件:

-

RAG構築などの社内独⾃のAI環境ではなく、有料版AIサービス利用を想定。

AI入力判断の鍵は、人の意識とプロセスの統制です。この3ステップのプロセスを実践することで、利便性を確保し、情報漏洩という致命的なリスクを回避できます。

入力しようとする情報が、上記「情報分類の3レイヤー」のどの層に該当するかを担当者自身が判定します。特にPII(個人識別情報)が含まれていないかを厳しくチェックします。

-

安全性が確保されていない外部AIサービスへの直接入力は厳禁とします。レイヤー1:機密情報は、そのままではAI協働に利用できません。

- 代替手段

-

AIを活用する場合は、以下のいずれかの方法で対応できるかを組織内で検討する。

- 匿名化・抽象化

-

情報全体を匿名化・抽象化処理し、レイヤー2以下に変換する工程を経る。

- 独自環境の利用: 組織が構築したセキュアな内部AI環境

-

例:RAG構築環境(社内の独自環境)のみで利用する。

上記の匿名化や独自環境の利用によって安全性が確認できた場合、またはレイヤー3の公開情報である場合に限り、AIへの入力を行います。

- 入力前に「本当にAIに入力して問題ないか?」と自問する習慣化が重要

- 入力情報が機密・社内限定・一般公開のどのレイヤーに該当するかを厳格に判断する

- PII(個人識別情報)の有無を確認する

- 安全性を確保していない外部AIサービスへの直接入力は厳禁。そのままではAI協働に利用しない

- 利用が必要な場合は、匿名化・抽象化へ情報変換するか、組織独自のセキュア環境(RAGなど)でのみ利用する

文章・資料作成におけるAI活用例の一覧

AI活用で外部・内部向けの文章作成においては、PII含む機密情報は一般名称へ変換してドラフト文の作成をAIに依頼する範囲に留めて、リスク回避を担保します。

| 業務内容 | 推奨される対応 |

|---|---|

| メールの返信文 | ドラフト文をAIが提案・作成し、宛名を入れた完成形は人間が作成 |

| 社内報告書 | 固有名詞を役割名に変換、機密情報は一般化したドラフト作成に利用 |

| 議事録の要約 | 参加者名を役職に変換した情報加工を施してAIへ依頼 |

| 稟議書の作成 | 金額を概算化、名前を役職に変換 |

| 業界動向などの調査 | そのまま利用可(出典先の確認作業は必須事項) |

| 顧客向け提案書 | 構成案や体裁、概念や企画骨子をAI協働とし、詳細部分は人間が作成 |

- 情報漏洩リスクが担保されないAI利用時には、PIIや機密情報は一般名称に変換し、外部・内部向け文書のドラフト作成に限定して利用

- ホワイトペーパーやウェブサイトでの公表など、AI出力を外部公開する際は、盗用リスク検証のため剽窃(ひょうせつ)チェックツールで確認を義務化

次に,情報入力において情報漏洩に対する安全意識を持つために、情報の匿名化・抽象化の変換方法を習得していきます。

情報の匿名化・抽象化の変換例

- 情報入力の実践5原則:

-

- 入力前の確認:AI入力前に「この情報は本当に入力して良いか?」と自問する習慣

- 最小限の情報提供:目的に必要な最小限の情報を段階的に提供

- 変換の徹底:迷ったら匿名化・抽象化を実施

- 出力の再確認:AI出力に入力情報が残っていないか確認

- 組織基準の優先:個人感覚ではなく自社や業界のガイドラインを参照

実務で最も判断に迷うのが「社内限定情報(レイヤー2)」の扱いです。以下の変換技術を用いて、情報の匿名化・抽象化を徹底することで、情報漏洩リスクを低減できます。

| 情報の種類 | 変換前(NG) | 変換後(OK) | 変換のポイント |

|---|---|---|---|

| 人名 | 「田中部長」 | 「営業部門責任者」 | 役割名への置換 |

| 企業名 | 「TOYO自動車」 | 「大手自動車メーカ」 | 業種・規模への抽象化 |

| 電話番号 | 03-0000-1234 | (削除) | 不要な情報は入力しない |

| 具体的数値 | 「売上3,250万円」 | 「売上3千万円台」 | レンジ幅で抽象化 |

| プロジェクト名 | 「Phoenixプロジェクト」 | 「新規事業プロジェクト」 | 一般名称化 |

| 製品名・ロット番号 | T12345 | 製造アーム部分 | 一般名称へ置き換え |

| 日時 | 「2026年3月15日」 | 「来期第1四半期」 | 期間表現 |

- 会社でのAI利用は、無償サービス版ではなく法人契約でデータの扱いを確認する

- PII含む機密情報は、全て削除や変換した上でドラフト作成の利用に留める

- 迷ったら「この情報で個人・企業・取引内容が特定できるか?」と自問する

どれだけ安全に情報を扱っても、法的リスクを見落とせば大きな問題に発展します。次は、個人情報に続いて重要な「著作権」「業界規制」という2つの法的リスクの観点で実践的な対応を習得します。

2-2.著作権と業界規制への対応

AI活用における法的リスクは、この「著作権」と「業界規制」の二側面を適切に管理することで、その法的課題を網羅・解決することが可能となります。

- 著作権侵害リスクへの対応

-

AIの生成物や入力プロンプトが著作権を侵害しないよう、以下の点に留意します。

対策 具体的な行動規範 AIサービスの利用規約の確認 利用するAIサービスの利用規約(著作権の帰属、データー学習の規定など)を確認した上で利用を開始する。 生成物(出力)の確認 テキスト: AI生成文章を外部公開する場合は、盗用チェック(剽窃チェッカー)を必須とする。 デザイン・画像(肖像権):AIが生成したデザインや画像に、既存の著作物との類似性がないかを目視で確認した上で、画像検索などで二次確認を行う。 入力データと利用範囲の制限 日本においてAIの学習や利用で著作物利用の範囲は、政府機関・専門家の判断が異なる部分もある。しかし、第三者のコンテンツをAIへ無断で「全文の要約」などは私用でも「複製権侵害のリスク」が高く避ける。「一部引用」の場合は、出典先を明記する。 - 業界規制の抵触リスクへの対応

-

金融、医療、公的機関など、業界固有の厳しい情報管理や倫理規制が存在する場合、AIの導入がこれらの規制に抵触しないかを確認する必要があります。

- 参考:業界別対応表(抜粋例:日本国内の業界別ガイドラインの一覧)

-

法令遵守に加えて、業界特有の自主規制や倫理的なリスクに備えるための実務的な指針を確認し、自社ガイドライン策定の参考にします。

以下は、日本国内における主要業界のAI活用ガイドラインの概要です。

-

業界 主な規制とガイドライン(公的機関・団体) AI活用時の重点管理項目 金融 ・FDUA(金融データ活用推進協会)「金融生成AIガイドライン」 機密性・プライバシー性の高い顧客情報の匿名化徹底。AIによる判断における透明性・説明責任の確保。データ品質の検証。 医療・ヘルスケア ・厚生労働省「医療デジタルデータのAI研究開発等への利活用に係るガイドライン」

・HAIP(医療AIプラットフォーム技術研究組合)「生成AI利用ガイドライン(第2版)」機微情報(病歴など)の厳格な匿名化・仮名加工。AIが生成する診断支援結果の臨床的検証プロセス(品質管理)など。 製造業 経済産業省(METI)「AI事業者ガイドライン」

AIの安全安心な活用を行い、AIの便益を最大化するために重要な「どのような社会

を目指すのか(基本理念=why)」 及び「どのような取組を行うか(指針=what)」 を示す。

- 機密情報やPIIのAIサービスへの入力は基本的に全面禁止とし、社内限定情報は必ず匿名化・抽象化する

- 情報分類に基づき、入力情報の種類とリスクを正確に識別し対応する

- 著作権対策として、利用するAIサービスの利用規約を最優先で確認し、遵守する

- 外部公開するAI出力は、盗用チェックや類似性の確認が不可欠とする

- AI活用で、業界固有の規制や国内外の法令に違反しないかを常に最新情報を確認する

法令遵守による「守り」の基盤を整え、「次なるステップは、何が正しいか」を問う、倫理的な価値判断の原則を学習していきます。

3.倫理的判断基準:価値観に基づく活用

法令やセキュリティ対策は「やってはいけないこと」の境界線を示しますが、AI協働においては、その境界線を超えた価値判断、すなわち「何故、それが正しいか」を説明できる倫理的説明責任が不可欠です。

本セクションは、AIがもたらすリスクへの最終的な防御線となる倫理的判断基準を確立し、これを個人のスキルとして習得し、組織体制の構築(ガバナンス構築)へ繋げる準備を行います。

3-1. AI倫理の「5原則」:倫理的リスク判断の羅針盤

AI活用における倫理的なリスク回避の土台となる、以下の5つの原則を判断の羅針盤として適用します。

- 補足

-

国際的なAI倫理原則は多岐にわたるため、本カリキュラムでは実務判断に直結する5要素に再編成しています。

判断の羅針盤:AI倫理の5原則の例

| 原則名 | 主な懸念 | 想定例 |

|---|---|---|

| 1.透明性 (Transparency / Explainability) | AIの判断根拠やプロセスが不透明なため、ユーザーや関係者がその結果を信頼するために、検証、確認する。 | 自動運転(事故原因究明)、人事評価(判断ロジック)、生成内容の信憑性(出典先の照合) |

| 2.公平性 (Fairness ) | AI出力が、データの偏りにより特定の集団(=ステークホルダー)に対して不当な格差や不利益をもたらす可能性を検証する。 | 採用審査(性別・人種バイアス)、融資審査(地域差)、保険料算定(不利な集団) |

| 3.人間中心 (Human-Centered Desin) | AIが生成した結果が、個人のプライバシーや尊厳、基本的な自由を侵害する可能性を検証する。 | 監視(プライバシー侵害)、誤情報(名誉毀損)、ヘイト表現(生成) |

| 4.責任の所在 (Accountability / Responsibility) | AI活用で問題が起きた際の最終的な責任を人間が担えるよう、確認工程やガイドラインを制定して準備する。 | 製品設計(製品安全性の問題)、医療(誤診の特定)、法務(法の解釈の確認) |

| 5.社会への影響 (Societal Impact) | AIシステムの導入が、雇用、地域社会、環境などに意図せぬ負の影響をもたらす可能性や現状に対応する。 | 環境負荷(データセンタ電力・水源の大量消費)、社会混乱(ディープフェイク) |

3-2. 倫理的ジレンマへの対処

AIを活用する際、しばしば二つの倫理原則が衝突する「倫理的ジレンマ」に直面します。これに直面した際は、価値判断の対立軸(例:敏捷性 vs 完成度、短期利益 vs 長期投資)を明確化し、ステークホルダーへの影響を考慮して「トレードオフの関係性」をガイドラインの方針やプロジェクト開始時に明示することが、組織的なリスク対処の基本となります。

- 公平性 vs. 利便性(効率):バイアスを完全に排除しようとすると、AIモデルの複雑さが増し、処理速度やコストが増加する。

- 透明性 vs. セキュリティ:AIの判断ロジック(仕組み)を全て公開すると、悪意ある者による攻撃(プロンプトインジェクションなど)の対象となり、セキュリティが低下する。

対処法:トレードオフの関係性の明示

ジレンマに直面した際の最善策は、どちらか一方を無理に選ぶことではなく、どちらの価値を優先し、その結果失う価値を明示する「トレードオフの関係性の明示」を行うことです。

- 価値観の特定: 衝突している価値(例:透明性とセキュリティ)を特定する。

- 優先順位の決定: 組織のミッションや業界規制に基づき、優先すべき価値(例:顧客情報保護のためセキュリティを優先)を決定する。

- 負の影響の最小化: 優先度を下げた価値(例:透明性)については、入力ログの記録や第三者監査で代替する対策を講じる。

3-3.最終判断の技法:人間による「検証 プロセス(Fact-Checking)」

AI協働におけるハルシネーション(虚偽情報の誤出力)やバイアスというリスクに対する、最も実践的な防御策となる検証技術を学びます。

この検証は、「複眼思考」を基本原則とし、「クリティカル思考の3段階検証」という具体的なステップで実行されます。

検証の基盤テクニック:「複眼思考」の応用

AIや情報源の提示する情報を多様な角度(視点)から検証する技術は、AI活用における基本原則の一つです。検証の際には、意図的にAIに異なる役割や批判的な視点を与え、別の角度からAI自身に再検証を要請する「多角的な検証」が効果的です。個人の立場だけでは見えない要素を発見し、評価の多角化を図ることで、最終判断の質を高めます。

| 検証法 | アクション(具体的な方法) | 例 |

|---|---|---|

| 多角的な検証 | AIに異なる役割や批判的な視点を与え、別の角度からAIに検証を要請する。 | 「弁護士として」「競合の立場から」といった別の視点で、AI自身に検証させる。 |

実践的な検証法:「クリティカル思考」の3段階検証

AIの生成情報を適切に評価するため、第2週で概念を習得したクリティカル思考を用いて、以下の3段階:「事実性」「論理性」「公平性(バイアス)」の検証を実践します。

- ファクトチェックの実践

-

AIの回答に含まれる固有名詞、数値、日時などが、客観的な事実として正しいかを確認します。このプロセスを実践することで、AIの生成する誤情報(ハルシネーション)を未然に防ぎます。

- 検証対象の特定:裏付けが必要な断定表現や主張・データの洗い出し

- 情報源の確認:実在する一次情報の存在と信憑性の照合

- 情報の裏付け:複数ソースで確認

- 根拠と主張の最終照合:矛盾の排除

- 真偽の最終決定:必要に応じて、判断根拠を記録

- 因果関係・整合性の確認

-

事実が正しくても、その「解釈」や「結論を導くプロセス」が正しいかを確認します。

- 因果関係の検証:「相関関係」と「因果関係」が混同されていないか、論理の飛躍がないかを確認します。

- 整合性の確認: AIの回答が、組織の既存の知識、ビジネスモデル、あるいは他の検証済み情報と矛盾していないかを確認します。前提条件が明示されているか、反証可能性が考慮されているかも重要なチェックポイントです。

- 相関≠因果:因果関係の検証:「相関関係」と「因果関係」が混同されていないか

- 論理の飛躍はないか

- 整合性の確認:AIの回答が、既存の知識や他の情報と矛盾していないか

- 前提条件は明示されているか

- 反証可能性はあるか

- バイアス類型と最終判断

-

倫理的な判断を行うための前提として、AI出力や判断プロセスに偏り(バイアス)がないかを検証し、是正します。

- データバイアス

-

AIの学習データに偏りがあるために、特定の集団に不利な結果を出力する。

- 対策

-

AIに「この提案には、どのような層のデータが欠けているか?」と問い、意図的に多様な視点(複眼思考)を組み込むよう指示する。

- アルゴリズムバイアス

-

AIモデルの設計や評価指標が、特定の目的や結果を過度に偏重してしまう。

- 対策

-

「提案を裏付ける根拠だけでなく、反対意見や、この提案が誰に不利益をもたらすか」をAIに検討させる。

- 認知バイアス

-

AIの回答を盲信したり、自分の都合の良い解釈をしてしまう。(確証バイアス)

- 対策

-

- 自分に都合の良い情報だけを採用していないか、意図的に反証を探す。

- 第三者(同僚)にAI出力を見せ、別の解釈を求める。

- AI出力の検証は、事実性、論理性、公平性の3段階で実行する

- 事実性の検証(ハルシネーション対策)は、固有名詞や数値を複数ソースで裏付けする

- 論理性の検証では、「相関関係」と「因果関係」の混同がないかを徹底的に確認する

- 公平性(バイアス)は、「データ」「アルゴリズム」「認知」の3側面から網羅的にチェックする

- AIに検証させる場合、「弁護士として」「競合として」など、複眼思考を活用する

- 最終責任の所在: AI出力は「提案」であり、「決定」は人間の責務

- 事実性の徹底検証: 固有名詞や数値など、客観的事実の裏付けで確認

- 論理性の確認: 導かれた結論と既存知識との整合性・因果関係を検証

- バイアス源の網羅: AIのデータ、アルゴリズム、確証バイアスの3側面などからリスクを確認

- 複眼思考の実践: 多角的な視点を問い、思考の偏りを排除

- 検証の習慣化: ハルシネーションとバイアスを防ぐためには検証を習慣化

3-4. 組織への定着化:「倫理ガイドライン」設定

「AI倫理(5原則)」を組織全体に浸透させるには、抽象的な理念で終わらせず、具体的な行動規範として公式文書に落とし込むことが不可欠です。

- ガイドラインの目的:

-

従業員がAIを利用する際の迷いや判断のばらつきをなくし、倫理的なリスク発生を未然に防ぐ。

- ガイドラインの主な基本骨子例:

-

※AI倫理5原則を、以下の3層の構造で実装する。

基本の構成 概要 1. 理念と原則(Philosophy Layer) AI活用の目的と、企業が最も重視する価値観を宣言する。イノベーションと信頼性の両立など、ガイドライン全体の方向性を定めます。 2. 行動規範と判断基準(Policy Layer) 従業員一人ひとりが日常業務で遵守すべき具体的なルールを提示する。リスクを避けるための「判断基準」を明文化します。 3. ガバナンス体制と運用(Governance Layer) ガイドラインの遵守を監視・実行する組織的な仕組みを定める。責任の所在とルール違反時の対応を明確化します。

AI倫理ガイドライン(日本語)の参考例3選:

小規模組織での実践方法

専門部署がない場合でも、既存の行動規範やコンプライアンス規程にAI活用に関する追記事項を設けることで、迅速に基盤を整備できます。

また、後述するリスクマップを活用し、特に優先度の高いリスクから対応ルールを定めるのが現実的です。

3-5. チーム・組織としての取り組み:責任の所在の明確化の必要性

AI活用におけるリスク管理は、個人の検証努力だけでは完結しません。組織としてAI導入を推進する以上、不測の事態が発生した場合の最終的な責任の所在を明確にすることが、企業の信頼と持続性の担保に不可欠です。

この「最終責任者」を定義する作業は、ガバナンス体制構築の核となります。プロジェクトチーム内で、誰が最終的な説明責任(Accountability)を負うかを明確に定める必要があります。

この役割と責任を詳細に定義するためのフレームワーク(例:RACIマトリクス)については、最終回(Vol. 4)で、組織全体へのガバナンス体制の設計プロセスの中で詳細に解説します。

- AI活用の羅針盤として、「透明性」「公平性」「人間中心」「責任の所在」「社会への影響」の5原則を理解し適用する

- 個人の判断力を高めるため、倫理的ジレンマを理解し、トレードオフの判断を行う

- AI出力の検証は、事実性、論理性、公平性(バイアス)の3段階で行う

- チーム・組織としてリスク管理へ取り組むため、行動規範となる倫理ガイドラインを設定する

- 組織としてのリスク対応には、最終責任者の明確化が不可欠であり、ガバナンス構築(Vol. 4で詳述)の起点となる

次章では、第3週の学習内容を整理し、実務で活用するための準備と、最終回(Vol.4)へ向けた解説を行います。

4. 第3週のまとめと次回への準備

第3週「実践リスク管理編」を通じて、AI活用の法的・倫理的リスクに対する防御と判断の枠組みを確立しました。次回の最終章(第4週)の組織への実践的な仕組みづくりに進む前に、今回の学習内容を確認します。

4-1. 第3週で習得した核心スキル

第3週では、法令遵守を超えた「何が正しいか」を判断する価値基準を確立しました。

| 項目 | 習得した内容 |

|---|---|

| 倫理原則の適用 | AI生成の情報や判断に対し、5原則を適用して倫理的リスクの有無を判断できるようになった。 |

| リスクの識別と対応 | PIIなどの機密情報の識別、著作権リスクを回避するための対応策を理解した。 |

| 検証技術の習得 | AI出力の検証は、事実性、論理性、公平性(バイアス)の3側面から行う実践的な技術を習得した。 |

| 責任の明確化の理解 | AI活用において、組織としての最終責任者の明確化が不可欠であることを理解した。 |

4-2. 第1週からの成長イメージ

成長イメージの比較

| 週 | 焦点 | 思考の変化 |

|---|---|---|

| Vol.1 | AI協働のマインドセット | AIを「単なる道具」ではなく、「人間が責任を担う協働者」として位置づけられる |

| Vol.2 | 問いの設計技法と指示 | 複雑な問いに対して、多角的な視点でAIからより質の高いアウトプットを引き出せる |

| Vol.3 | 実践リスク管理 | 出力されたAI情報に対して、法的・倫理的リスクがないかを自立的に検証し、リスク回避ができる |

よくある課題と対処法

第3週で多くの人が直面する課題とその対処法を共有します。

課題1:倫理的判断の5原則の実務判断の迷い

症状: 5原則が抽象的で、どのように実行すべきか分かりづらい。

対処法:5原則のうち、透明性と公平性を最優先のチェックポイントとし、具体的な「ステークホルダーへの不利益」がないか、まず検証することが基本の流れとなります。

課題2:個人情報のリスク管理が個人の意識に依存する懸念

症状: 機密情報やPIIの入力禁止ルールが個人の意識に依存し情報漏洩が危惧される。

対処法:利用環境の制限と相互チェックでリスクを防ぎ、判断の根拠を育む。

- 安全が担保されてない無償AIサービスの個人利用で会社情報の入力禁止を周知徹底する。

- AI活用の初級者には、ピアレビュー(対人の相互チェック)方式で、AI活用時に「バディー制度」を推奨する。

- 法人契約するAIサービス事業者に、「入力フィルターの有無」を確認する。

課題3:倫理的ジレンマのトレードオフ判断の困難

症状: 倫理的ジレンマに直面したとき、トレードオフの判断ができず、プロジェクトが停滞する。

対処法:「人間中心」の原則に立ち返り、最も影響が大きくなるとステークホルダーへの不利益を最小化する選択枝を優先に採択する。その一時的に放棄した価値(例:透明性)に対しては、監査ログなどシステムによる事後検証の仕組みを徹底することでリスクを管理する。

4-3. 自己評価チェックリスト

第3週の学習の到達度を、各自で確認してみましょう。

ナレッジ・理解面:

- 法令と倫理の違いを明確に説明できる

- AI倫理の5原則(透明性、公平性、人間中心、社会影響、責任の所在)を説明できる

- 「倫理的ジレンマ」が、リスク対処における具体的な一歩であることを説明できる

スキル・実践面:

- 自社のAI活用事例に対し、5原則に基づく倫理的なリスク(ハーム)を3つ以上指摘できる

- AIプロジェクトにおいて、最終責任者(Accountable)を明確に定める必要性を言語化できる

- 「人間中心」の原則に基づき、AI利用者の視点から懸念事項を言語化できる

マインド・習慣面

- AIの利用結果に対し、「便利だからOK」ではなく、「倫理的に説明できるか」という視点を持っている

- 責任の所在を曖昧にせず、人間が最終責任を負うという意識がある

- 倫理はイノベーションを制限するものではなく、信頼性を高める基盤であると認識している

次に、第3週の終わりにグループワークを開催して、意見交換をして互いの学びを共有してみましょう。新たな発見があるかもしれません。

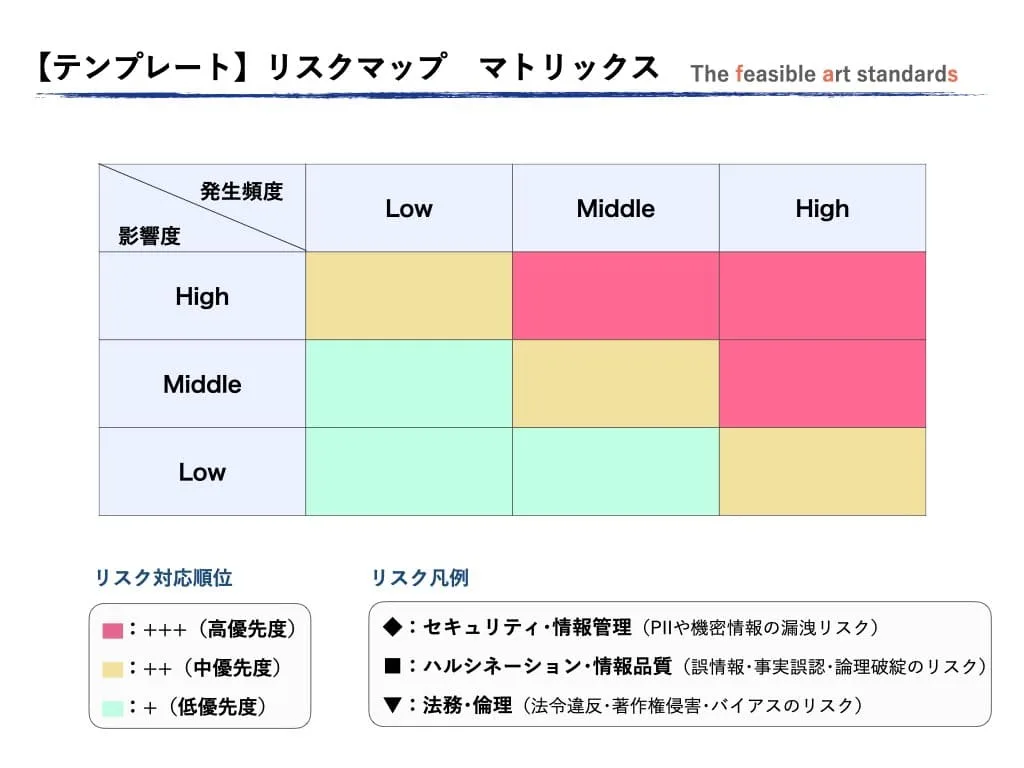

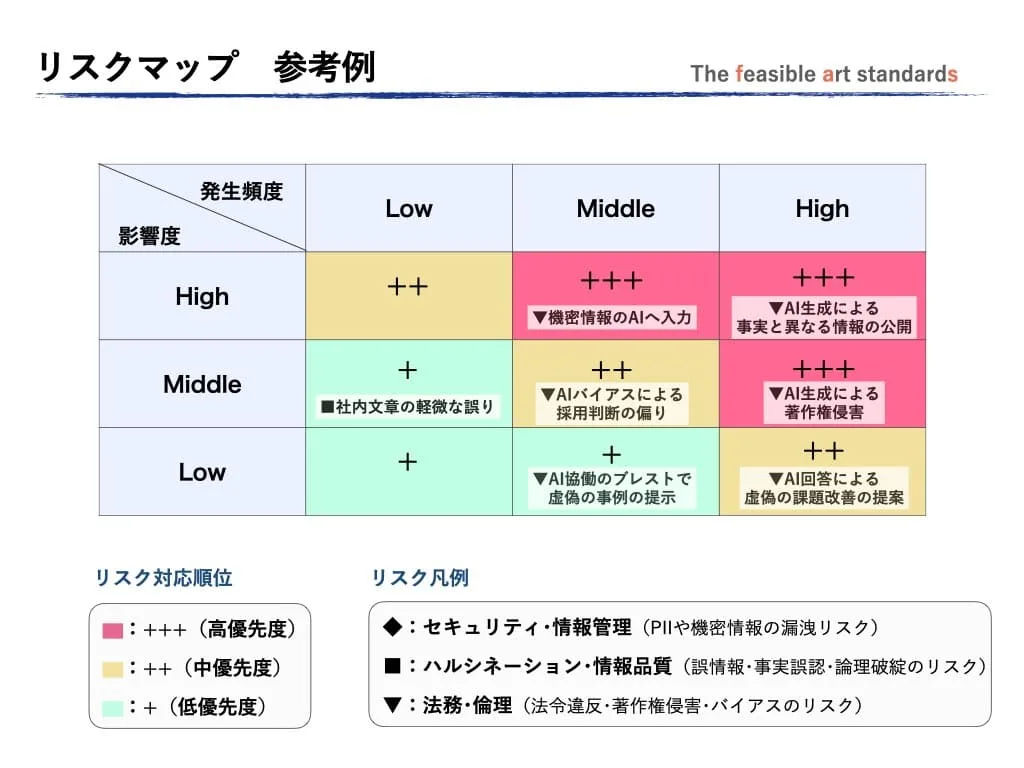

4-4. グループワークガイド:リスクマップ作成(目安:60分)

次回の最終講座:Vol.4で学ぶ「リスクアセスメント」(AI影響評価:AIシステムが潜在的に持つ倫理的・法的・社会的な負の影響を事前に特定し、評価するプロセス)」の予行演習として、自社または仮想のAI活用事例に基づき、グループワークでリスクマップを作成します。

1人で学習している場合は、学んだ内容をAIに説明し、AIからフィードバックをもらう練習を実施します。

個人の学びを共有する(10分)

- AI活用のリスク管理で、最も重要と感じた倫理原則を一つ選び、その理由をグループ内に共有する。

グループワーク:リスクマップ作成 (40分)

リスク評価基準の目安(例)

- 影響度:金銭的損害、改善対応に要する時間損失など

- 発生頻度:年間の発生(予測)件数など

| 評価軸 | リスク分類 | 例 |

|---|---|---|

| 影響度 | High | PIIや機密情報の漏洩リスク |

| Middle | 信頼低下・対応コスト | |

| Low | 軽微な修正で対応 | |

| 発生頻度 | High | 月1回以上 |

| Middle | 四半期1回程度 | |

| Low | 四半期1回程度 |

リスク分類

| 凡例 | リスク分類 | 主な要因 | 例 |

|---|---|---|---|

| ◆ | セキュリティ・情報管理 | 人間の情報の扱い | PIIや機密情報の漏洩リスク |

| ■ | ハルシネーション・品質 | AI出力の信憑性 | AI出力の誤情報、事実誤認、論理の破綻などの生成リスク |

| ▼ | 倫理・法務・コンプライアンス・バイアスリスク | AI出力と人間の検証漏れ | 法令違反、著作権侵害、バイアスの発生 |

リスク対応優先度

| 凡例 | 優先度 | 対応例 |

|---|---|---|

| +++ | 高 | プロジェクトを一時停止し、経営層への即時報告と急務の対応が必要 |

| ++ | 中 | 対応計画を策定し、責任者をアサイン。週次で進捗を監視 |

| + | 低 | 現在の業務プロセス内で許容し、四半期ごとに発生頻度をチェック |

決定したテーマから想定されるインシデントを考えて、これらリスク分類とリスク対応優先度を参照してリスクマップを作成します。

リスクマップの作成手順

- 1.テーマの選択と決定(5分)

-

- 以下のAI活用における参考テーマから1つ、または、自社課題のAI活用でリスク管理のテーマを決定する。

-

- 参考テーマ1:社内会議の議事録の作成

- 参考テーマ2:外部向けの返信メールや資料作成

- 参考テーマ3:業務改善におけるアイデア会議の参加

- 2.リスクの洗い出し(15分)

-

決定したテーマに対し、「5原則」に基づき付箋紙を利用して想定される被害をできるだけ多くリストアップする。

- 3.リスクのマッピング(10分)

-

各リスクを、「影響度(High/Middle/Low)」と「発生頻度(High/Middle/Low)」で評価し、マトリクス上の適切な位置に付箋を貼る。

- 3.対処法の議論(10分)

-

最も優先度が高くなったリスク(+++)に対し、グループとしてどのような対処策(コントロール)を適用すべきか議論し、まとめる。

感想の共有(10分)

ワーク内容で興味深かった点や、困難であったことをグループで感想を共有して終了する。

- 議論を深めるため、「誰が最も不利益を被るか?」とステークホルダーの視点に常に立ち戻らせる

- 「責任の所在」が誰になるのかを明確に定義し、その人物がリスクを負えるかを検討する

- リスク評価が抽象的になったら、「そのリスクが起きたら、会社の評判はどうなるか?」「法的に訴えられるか?」など、具体的な影響を問う

4-5. 最終週への準備

- 最終章で学ぶこと:

-

- これまでに確立した原則を、具体的なガバナンス体制として組織に組み込む方法を学びます。

-

- AIリスクのアセスメント(導入前の評価)の具体的な実行手順

- AIガバナンス体制の設計と、継続的なモニタリングの仕組み

- 準備事項:

-

自社で導入予定、または活用しているAIシステムを一つ選び、そのAIがデータ活用の「透明性」に関してどのような課題を抱えているか事前に調べておく。

次回の学習ガイダンス

第4週は、これまでの「Why(なぜ必要か)」の理解を「How(どう実現するか)」に昇華させます。リスクを特定するだけでなく、「どのようにリスクを組織として回避できるか」という具体的なガバナンス構築と解決策を意識して学習に臨んでください。

エピローグ

リスク管理が開く新しい可能性

AI倫理とリスク管理は、しばしば「規制」や「コスト」として捉えられがちです。しかし、真に成熟したAIガバナンス体制は、単なる防御策ではありません。

- 信頼性の獲得:倫理的な透明性と公平性を担保することで、顧客や社会からの信頼という、最も強力な無形資産を築く礎になります。

- イノベーションの加速:リスクを明確に把握し管理下に置くことで、恐れることなく新しいAI技術の領域に大胆に踏み込むことが可能になります。

倫理的判断を含む適切なリスク管理は、AI時代における「新しい形の競争優位性」となります。

最終章(第4週)への期待

最終章では、これまで学んだ原則を統合し、AIを責任を持って活用するための実践者としての役割を確立します。あなたはAI協働の学習者から、組織の信頼性を担保する設計者へと進化します。

最後の仕上げとして、実務に役立つ具体的な仕組みづくりを徹底して学びます。

この記事のURLをNotebookLMに読み込むと、音声解説や理解度クイズなどを自動生成し、空き時間の個別学習にも活用できます。

生成AIを活用するための「ミニ用語集」

※各タイトルをクリックすると、詳細な解説が表示されます。

AI協働アシスタント

AIを単なる道具ではなく、対話を通じて思考を深める存在として捉える概念。

問いの設計

適切な背景情報と制約条件を提供し、有用な回答を引き出す質問を構築する能力。

構造化

複雑な問題を要素分解し、論理的な関係性を整理すること。

AIの推論能力

回答に至るまでの思考プロセス(論理的なステップ)を段階的に示すことで、より複雑な問題解決や正確な結果を生成する能力。

メタ認知

自他の思考プロセスを客観的に認識し、制御する能力。

クリティカル思考

情報を盲信せず、その妥当性・信頼性・論理性を検証する思考態度。

複眼思考

多様な観点で観察し視野を広げる思考技法。

創造的発想

異なる情報を結合させて、新たな価値を導き出す思考技術。

PII (Personally Identifiable Information)

個人識別情報。氏名、住所など、個人を特定できる情報。AIへの入力は厳禁。

ハルシネーション

AIがもっともらしい誤情報を生成する現象。(Vol3で対策を詳述)

トレードオフ関係

一方を選ぶと他方に影響にする関係。

AIの事前評価

AIが社会や人に与える損害を、導入前に特定・評価するプロセス。これにより、潜在的なリスクを事前に管理可能にする。

倫理的ジレンマ

2つの倫理的に正しいとされる価値や原則が衝突し、どちらか一方を選ばなければならない状況。AI活用において、効率性と公平性が対立する場面などで発生する。

トレードオフの判断

倫理的ジレンマにおいて、衝突する価値観(例:速度 vs 安全性)のうち、どちらを優先し、なぜ他方を許容するかを明確に判断し、公開すること。責任ある判断の根拠となる。

AI倫理の5原則

AIを安全に活用するための判断基準:「透明性」「公平性」「人間中心」「責任の所在」「社会への影響」

人間中心 (Human-Centered Design)

AIの設計・利用において、人間の尊厳、安全、幸福を常に最優先するという基本的な倫理原則。AIを人間の道具として位置づける。

バイアス (Bias)

AIの学習データやアルゴリズム、あるいは人間の認知における偏り。特定の集団に不公平な結果をもたらす。

ハルシネーション (Hallucination)

AIが事実に基づかない、誤った情報を出力すること。検証プロセスが最大の防御策となる。

RACIマトリックス

プロジェクトの役割と責任を、「実行 (Responsible)」「責任 (Accountable)」「相談 (Consulted)」「報告 (Informed)」の4つに明確に分類し定義する手法。AI利用において、最終的な責任の所在を曖昧にしないために活用される。

参考文献&WEBサイト

- 岡瑞起ほか 「『AI時代の質問力』 プロンプトリテラシー 」:翔泳社 2024年

- 安藤昭子 「問いの編集力 思考の『はじまり』を探究する」:ディスカヴァー・トゥエンティワン社 2024年

- デジタル庁「行政の進化と革新のための生成AIの調達・利活用に係るガイドライン」:2025年10月15日閲覧

- デジタル庁「デジタル社会推進標準ガイドライン:DS-310 政府情報システムにおけるクラウドサービスの適切な利用に係る基本方針(PDF/800KB)」:2025年10月17日閲覧

- SATORIA法律事務所/ブログ「連載:AIと著作権 ― 実務に効く連載シリーズ」:2025年10月18日閲覧

- 日経XTECH【有料版】「AI暴食を止められない著作権法、コンテンツ使われっ放しへの対処に限界」:2025年11月18日閲覧

- Forbes Japan「プロフェッショナル育成におけるAI活用の新時代」:2025年10月18日閲覧

X(旧ツイッター)やフェースブックのアカウントをフォローを頂くと最新記事を読み逃すことなく閲覧頂けます。